Der erste Kontakt zwischen dem NSX-T Manager und dem vCenter und das Vorbereiten der Hosts, damit bereits die ersten Segmente deployed werden können (Virtualwire).

Die Hosts habe ich in einen Cluster geschoben, damit später jeder Host, welcher in den Cluster kommt, sich selber an den NSX hängt.

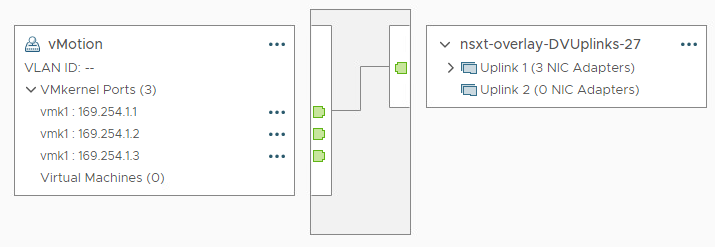

Damit NSX-T später entsprechend seine Konfiguration deployen kann, muss im vCenter ein neuer Switch erstellt werden. Für meine Zwecke habe ich mir einen dvSwitch (distributed) erstellt.

Da es sich hier nur um ein nested Lab handelt, habe ich zwar 2 Uplinkpfade erstellt, aber nur 1 pNic angebunden. Gleichezitig nutze ich die Ports auch gleich für vMotion. Den APIPA Bereich habe ich absichtlich gewählt, da diese IPs nie gerouted werden sollen, was so auch auf mein vMotion Netz zutrifft.

Nachdem der Switch erstellt wurde, kann nun das vCenter im NSX-T Manager eingetragen werden. Klar kann man das vCenter auch zuerst registrieren, vom Ablauf her kann man aber so zuerst das vCenter vorbereiten und dann im NSX-T weiter durcharbeiten.

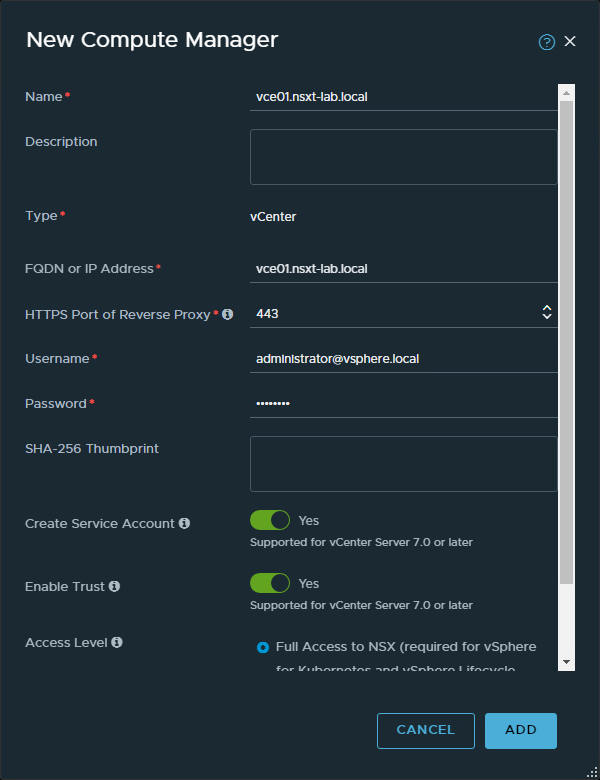

Nach dem Anmelden am NSX-T Manager wechselt man in das folgende Menu: “System -> Fabric -> Compute Managers”. Da wählt man entsprechend “+ Add Compute Manager”. Im folgenden Dialog füllt man nun alle vCenter relevanten Daten aus.

By the way: Aus Security Gründen sollte man nicht den SSO Admin für die Verbindung nutzen, für ein Homelab mag das gehen, aber bitte niemals für eine Produktion.

Speziell sind die die Optionen “Create Service Account” und “Enable Trust”, die sind notwendig für die Anbindung an ein vCenter mit der Version 7.0 und neuer.

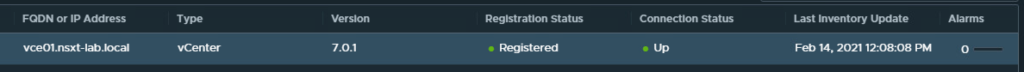

Danach ein klick auf Add, das Zertifikat bestätigen und dann heisst es warten. Was passiert hier nun? NSX-T trägt sich im vCenter ein und erstellt seine Accounts und Berechtigungen. Wenn das alles geklappt hat, sieht das wie folgt aus:

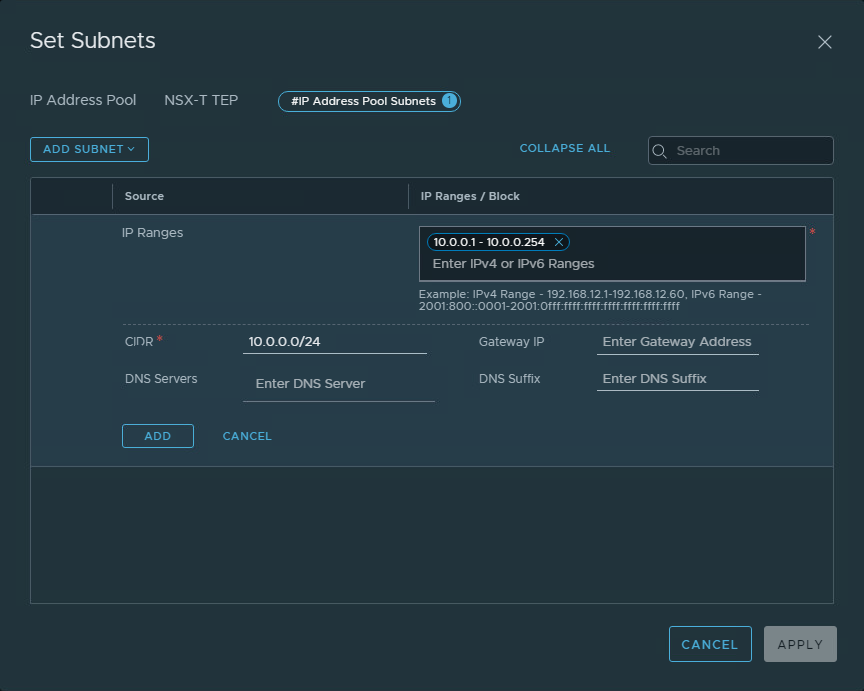

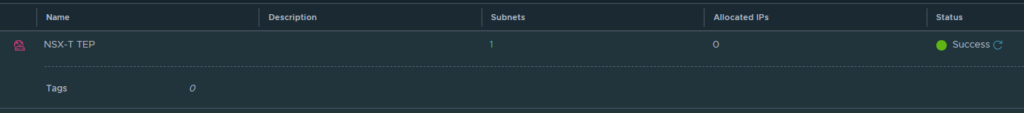

So nun geht es an die Vorbereitung des IP-Pools. Unter “Networking -> IP Address Pools” kann man solche Pools erstellen. Dazu klickst du auf “Add IP Address Pool”. Meinen Pool nenne ich “NSX-T Lab TEP”. Unter Subnets steht “Set” und darunter kannst du nun den IP Range erstellen.

In diesem Fall hab ich auf ein A-Class Netz mal zurückgegriffen. Nach dem Bestätigen aller Dialoge sieht das dann so aus:

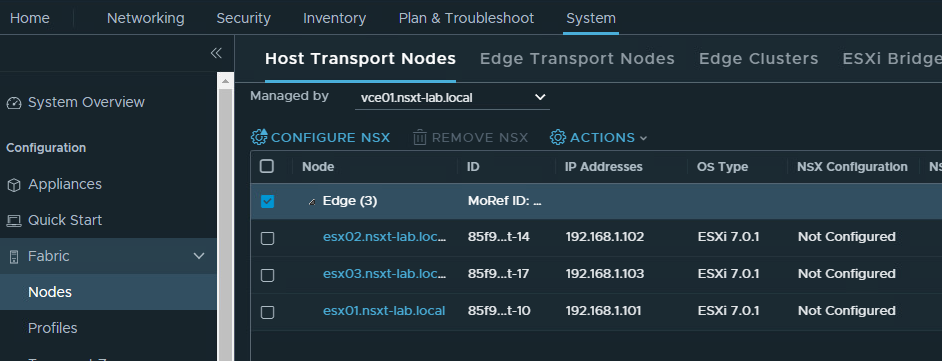

Auf diesen Pool greifen wir gleich beim Einrichten des Clusters zu. Nun gehts zurück auf das Register Nodes unter System -> Fabric. Dort das vCenter auswählen und den Cluster anklicken.

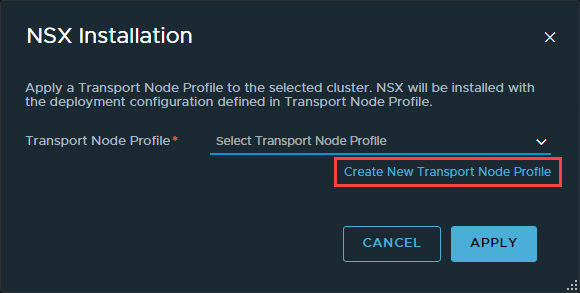

Im nächsten Dialog gehts gleich weiter in den Dialog zum Erstellen des “Transport Node Profiles”.

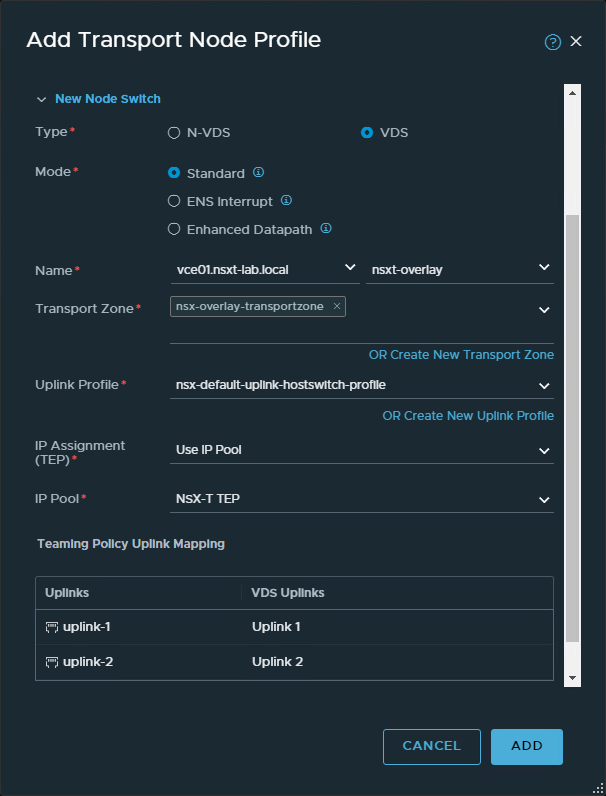

Auf die entsprechenden Paramtere werde ich später in einem anderen Beitrag eingehen. Hier linken wir den erstellten dvSwitch mit dem NSX und konfigurieren das Uplinkprofil mit aktive/standby. Als IP Zuweisung setzen ich nun den IP-Pool ein, den ich vorher erstellt habe. Dann noch die beiden Uplinks dem Profil zuweisen und hinzufügen.

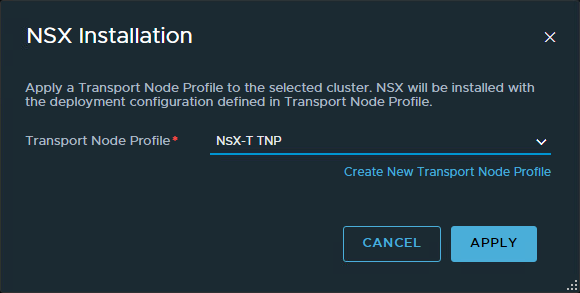

Anschliessend wird das Profil angewendet auf den Cluster.

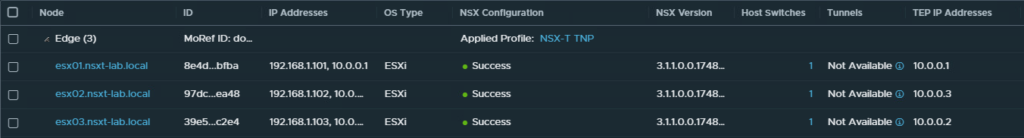

Es dauert nun eine Weile, bis die NSX VIB auf dem Host installiert ist und anschliessend und der TEP aktiv ist. Man erkennt auch die TEP-IP, sprich alles klappt wie gewünscht.

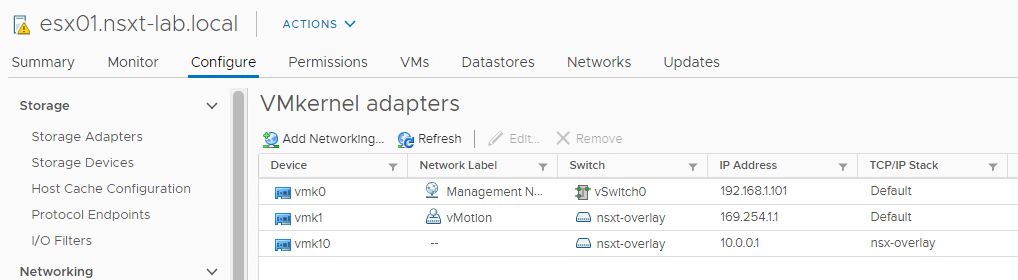

Das kannst du auch auf dem ESXi prüfen ob alles funktioniert hat. Denn für den TEP wird ein TCP/IP Stack erstellt und ein Kernel angelegt im entsprechenden Stack.

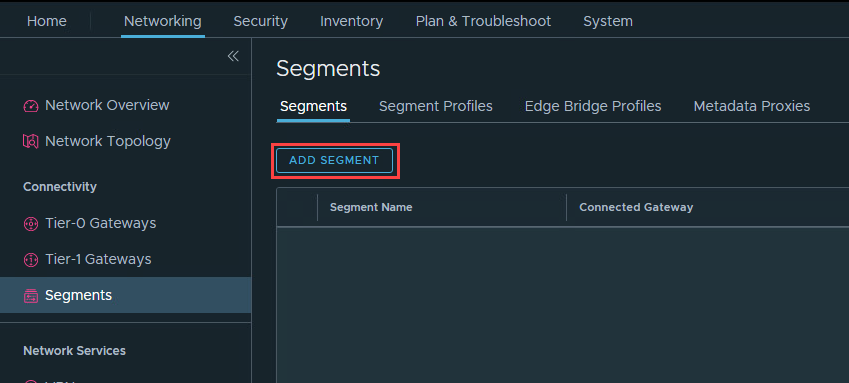

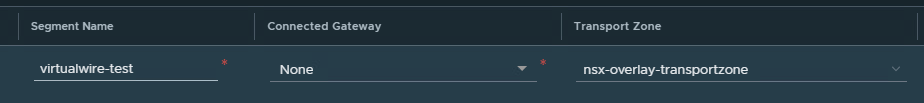

Nun gehts ans Testen. Unter “Networking -> Segements” legen wir mal ein Segement, oder wies bei NSX-V genannt wurde, virtualwire.

Das Segment soll nicht grossartig was können, es dient nur dazu, um zu testen ob die Verbindungen klappen. Darum auch nur der Segmentname und die Transportzone ausfüllen und go.

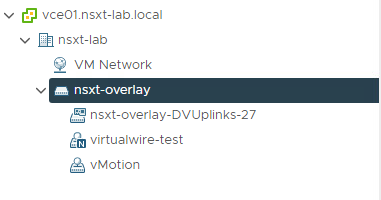

In wenigen Sekunden wird dies bestätigt und ein Blick ins vCenter zeigt, obs geklappt hat.

Fertig ist das isolierte virtualwire, auf dem kann man bereits VMs auflegen und die VMs können miteinander kommunizieren.